مقدمه: چرا Robots.txt و Sitemap.xml بیش از آنچه فکر میکنید اهمیت دارند؟

رفقا، وقتی حرف از سئو میشه، اغلب میریم سراغ کلمات کلیدی، محتوا و لینکسازی. اما یه بخش حیاتی و فنی وجود داره که خیلیها ازش غافل میشن یا فقط در حد تنظیمات اولیه بهش نگاه میکنن: فایلهای Robots.txt و Sitemap.xml. این دوتا، در حقیقت، راهنماهای اصلی گوگل و بقیه موتورهای جستجو هستن برای اینکه چطور سایت شما رو پیدا کنن، بخزن و ایندکس کنن.

تصور کنید گوگل یک ربات پر تلاش و وظیفهشناسه. این ربات برای اینکه کارش رو درست انجام بده، به نقشه و دستورالعمل نیاز داره. Robots.txt بهش میگه: "آقا رباته! از این مسیرها برو، از اون یکی نرو." و Sitemap.xml بهش میگه: "اینا مهمترین صفحات منه، لطفاً اینا رو حتماً ببین." حالا اگه این دستورالعملها بهینه و دقیق نباشن، ربات گوگل ممکنه سردرگم بشه، صفحات بیاهمیت رو بخزه و صفحات مهم رو از دست بده. نتیجه؟ اتلاف بودجه خزش (Crawl Budget) و کاهش رتبه شما!

امروز میخوایم از نگاه یک متخصص فولاستک، نه فقط در حد نصب یه افزونه، بلکه با رویکرد کدنویسی، به این دوتا فایل حیاتی نگاه کنیم و یاد بگیریم چطور از پتانسیل کاملشون برای تسلط بر خزش گوگل استفاده کنیم. آمادهاید؟ بریم که داشته باشیم!

Robots.txt: مدیر ترافیک رباتها در سایت شما

فایل Robots.txt در ریشه سایت شما قرار میگیره و قبل از هر چیز، به رباتهای موتور جستجو میگه که مجاز به خزش کدوم قسمتهای سایتتون هستن و کدوم قسمتها رو نباید ببینن. هدف اصلی؟ مدیریت بودجه خزش و جلوگیری از ایندکس شدن صفحات بیاهمیت یا تکراری.

چالشهای Robots.txt پیشفرض و افزونهای

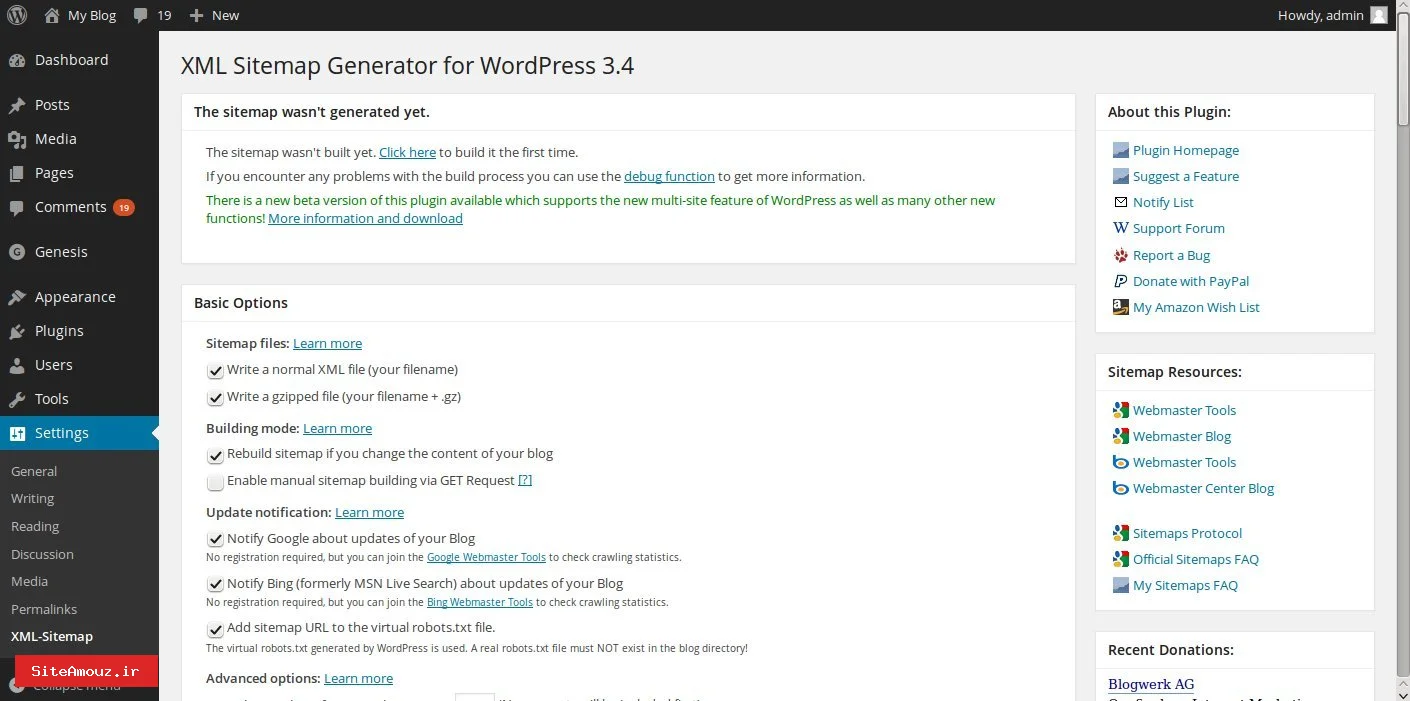

وردپرس به صورت پیشفرض یک Robots.txt مجازی تولید میکنه که معمولاً خیلی ساده است. افزونههای سئو هم گزینههای خوبی برای مدیریت این فایل دارن، اما گاهی اوقات، برای سناریوهای پیچیدهتر، نیاز به کنترل granular و کدنویسی داریم. مثلاً:

- وقتی صفحات توسعه یا استیجینگ داریم که نباید ایندکس بشن.

- وقتی دایرکتوریهای خاصی شامل فایلهای موقت یا تست هستن.

- وقتی میخوایم یک سری از پارامترهای URL رو دیسالو (Disallow) کنیم تا صفحات تکراری ایجاد نشن.

فوت کوزهگری: شخصیسازی Robots.txt با کدنویسی در وردپرس

برای اینکه کنترل نهایی رو داشته باشیم، میتونیم از هوک (Hook) robots_txt در وردپرس استفاده کنیم. این هوک به ما اجازه میده خروجی نهایی فایل Robots.txt رو قبل از ارسال به رباتها، دستکاری کنیم.

function my_custom_robots_txt_directives( $output, $public ) {

// همیشه اجازه دسترسی به فایلهای آپلود شده رو بدید

$output .= "Allow: /wp-content/uploads/

";

// دیسالو کردن دایرکتوریهای توسعه یا استیجینگ

$output .= "Disallow: /wp-content/themes/mytheme/dev-assets/

";

$output .= "Disallow: /staging-site-area/

";

// دیسالو کردن صفحات دارای پارامتر خاص (مثلاً نتایج فیلترهای زیاد)

$output .= "Disallow: /*?filter=*";

// اگر سیتمپ رو به صورت دستی مدیریت میکنید، میتونید اینجا اضافه کنید

// $output .= "Sitemap: " . site_url('/sitemap.xml') . "

";

// بچهها دقت کنید: اگر سایتتون Public نباشه، وردپرس خودش دیسالو میکنه

// پس نیازی به چک کردن $public اینجا نیست مگر برای منطق خیلی خاص.

return $output;

}

add_filter( 'robots_txt', 'my_custom_robots_txt_directives', 10, 2 );

من توی پروژههام دیدم که عدم کنترل دقیق روی

robots.txtچطور باعث خزش بیمورد صفحات بیاهمیت و اتلاف بودجه خزش شده. با این روش کدنویسی، میتونید کاملاً مشخص کنید ربات گوگل کجا بره و کجا نره. این یعنی بهینهسازی دقیقتر برای سئو فنی.

Sitemap.xml: نقشه راه طلایی سایت شما برای گوگل

فایل Sitemap.xml به رباتهای موتور جستجو لیستی از تمام URLهای مهم و قابل خزش در سایت شما رو ارائه میده. این فایل برخلاف Robots.txt که میگه "چی رو نبین"، میگه "چی رو حتماً ببین". یه Sitemap.xml بهینه، به گوگل کمک میکنه محتوای سایت شما رو سریعتر و کاملتر کشف کنه.

Sitemap پیشفرض وردپرس و نیاز به توسعه

از وردپرس نسخه 5.5 به بعد، یک قابلیت Sitemap پیشفرض اضافه شده که کار رو راحتتر کرده. اما باز هم برای پروژههای بزرگ یا نیازهای خاص، ممکنه کافی نباشه. مثلاً:

- وقتی میخوایم یک سری از پستها یا صفحات رو عمداً از سیتمپ حذف کنیم.

- وقتی میخوایم سیتمپهای اختصاصی برای ویدئوها، تصاویر یا اخبار بسازیم.

- وقتی صفحات خاصی داریم که به صورت پیشفرض در سیتمپ وردپرس قرار نمیگیرن اما برای ما مهمن.

فوت کوزهگری: کنترل Sitemap.xml با کدهای وردپرس

وردپرس هوکهای مختلفی برای مدیریت سیتمپها داره. از طریق این هوکها، میتونیم پست تایپها، تاکسونومیها و حتی URLهای خاصی رو به سیتمپ اضافه یا از اون حذف کنیم. اینجاست که مهارت برنامهنویسی PHP برای سئو فنی به کارتون میاد.

حذف پست تایپها یا تاکسونومیهای خاص از Sitemap

// حذف یک پست تایپ خاص از سیتمپ وردپرس

function my_custom_sitemap_post_types( $post_types ) {

unset( $post_types['my_custom_post_type_to_exclude'] ); // اسلاگ پست تایپ مورد نظر رو اینجا بنویسید

return $post_types;

}

add_filter( 'wp_sitemaps_post_types', 'my_custom_sitemap_post_types' );

// حذف یک تاکسونومی خاص از سیتمپ وردپرس

function my_custom_sitemap_taxonomies( $taxonomies ) {

unset( $taxonomies['my_custom_taxonomy_to_exclude'] ); // اسلاگ تاکسونومی مورد نظر رو اینجا بنویسید

return $taxonomies;

}

add_filter( 'wp_sitemaps_taxonomies', 'my_custom_sitemap_taxonomies' );

حذف پستها یا صفحات خاص بر اساس ID از Sitemap

function my_custom_sitemap_exclude_specific_items( $args, $post_type ) {

// فرض کنید میخوایم پست با ID 123 و صفحه با ID 456 رو از سیتمپ حذف کنیم

if ( 'post' === $post_type || 'page' === $post_type ) {

$excluded_ids = array( 123, 456 );

if ( isset( $args['post__not_in'] ) ) {

$args['post__not_in'] = array_merge( $args['post__not_in'], $excluded_ids );

} else {

$args['post__not_in'] = $excluded_ids;

}

}

return $args;

}

add_filter( 'wp_sitemaps_posts_query_args', 'my_custom_sitemap_exclude_specific_items', 10, 2 );

بچهها دقت کنید،

Sitemap.xmlفقط یه لیست از URLها نیست؛ نقشه راهیه که شما به گوگل میدید تا مهمترین جاهای سایتتون رو پیدا کنه. با این فوتوفنها، شما عملاً دارید به گوگل میگید "کدوم صفحات رو در اولویت قرار بده".

همافزایی فولاستک: ترکیب Robots.txt و Sitemap.xml برای حداکثر تاثیر

حالا که با بهینهسازی هر کدوم به صورت جداگانه آشنا شدید، مهمترین بخش اینه که چطور این دو رو با هم هماهنگ کنیم تا حداکثر بهرهوری رو داشته باشیم:

- اعلام Sitemap در Robots.txt: همیشه مطمئن بشید که آدرس فایل

Sitemap.xml(یا Sitemap Index) درRobots.txtشما ذکر شده باشه. این کار به رباتهای گوگل کمک میکنه تا خیلی سریع نقشه راه سایت شما رو پیدا کنن. - عدم تضاد: هرگز صفحهای رو در

Sitemap.xmlقرار ندید که درRobots.txtدیسالو (Disallow) شده باشه! این کار باعث سردرگمی رباتها میشه و تجربه خوبی نیست. اگر صفحهای مهم نیست و نباید خزش بشه، نه درRobots.txtبهش اجازه بدید و نه درSitemap.xmlاون رو لیست کنید. - اولویتبندی خزش: با ترکیب این دو، میتونید به صورت هوشمندانه مسیرهای خزش رباتها رو به سمت محتوای با ارزش و تازه هدایت کنید. این یعنی استفاده بهینه از بودجه خزش شما.

نکات کلیدی و "فوت کوزهگری" پایانی آقا کوچولو

- تست، تست، تست: بعد از هر تغییری در

Robots.txtیاSitemap.xml، حتماً از ابزار Google Search Console استفاده کنید. بخش "Robots.txt Tester" و "Sitemaps" بهترین دوستان شما هستن برای تشخیص خطاهای پنهان سئو. - حواستان به دایرکتوریها باشد: اگه دایرکتوریهایی مثل

/wp-json/یا/xmlrpc.phpرو دیسالو میکنید، از درست کار کردن افزونهها و سرویسهایی که بهشون نیاز دارن مطمئن بشید. - Sitemap Index برای سایتهای بزرگ: اگه سایت خیلی بزرگی دارید، بهتره از Sitemap Index استفاده کنید که شامل لینک به چندین سیتمپ کوچکتر (مثلاً سیتمپ برای پستها، سیتمپ برای صفحات، سیتمپ برای محصولات و غیره) است. این کار مدیریت رو آسونتر میکنه.

رفقا، فوت کوزهگری اینجاست که شما با ترکیب دقیق Robots.txt و Sitemap.xml، به جای اینکه منتظر بمونید گوگل سایتتون رو کشف کنه، عملاً بهش دیکته میکنید که کجا بره و کجا نره. این یعنی کنترل نهایی روی Crawl Budget و Indexability. با رویکرد فولاستکی که بهتون گفتم، میتونید از تمام پتانسیل سایتتون برای کسب رتبههای بالاتر در گوگل استفاده کنید.

جمعبندی

در این پست، دیدیم که چطور با کمی کدنویسی و درک عمیق از نحوه کار موتورهای جستجو، میتونیم از Robots.txt و Sitemap.xml فراتر از یک تنظیم ساده استفاده کنیم. این ابزارها، وقتی به درستی و با نگاه فولاستک بهینهسازی بشن، میتونن تفاوت چشمگیری در عملکرد سئوی سایت وردپرسی شما ایجاد کنن. پس دست به کار بشید و با تسلط بر این فوتوفنها، راه رو برای رباتهای گوگل هموارتر کنید تا بهترین محتوای سایت شما رو پیدا کنن و ایندکس کنن. موفق باشید!